El ChatGPT ya ha se ha leído casi todo lo que hay volcado en internet. Pero esta proeza no ha resuelto ni de lejos sus problemas de diversidad ni su falta de razonamiento.

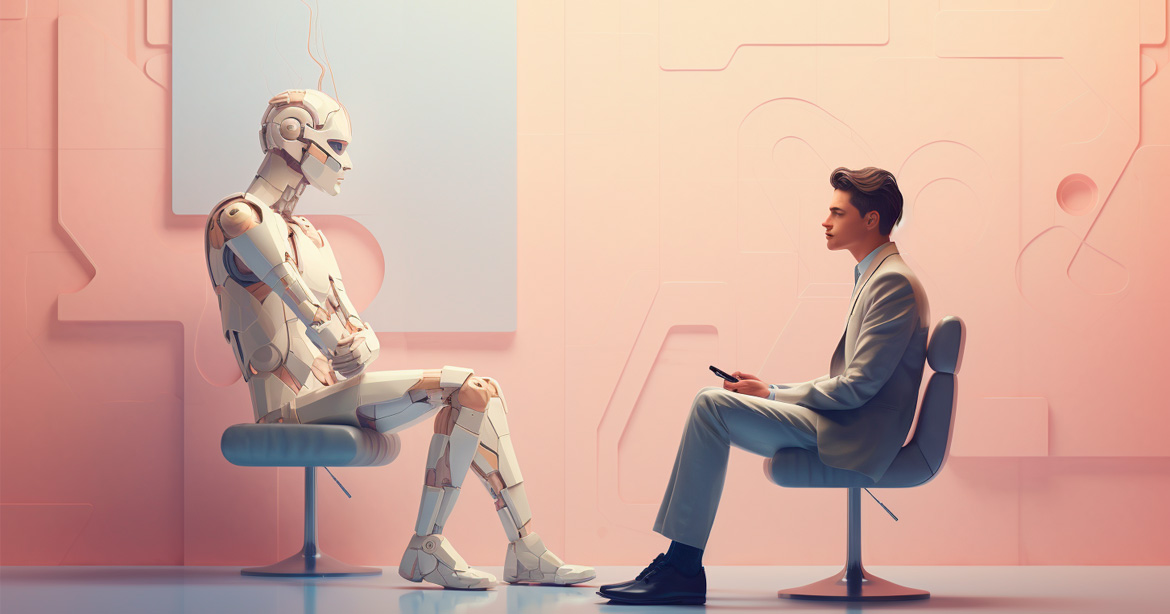

Los modelos lingüísticos de inteligencia artificial (IA) están en auge. El más avanzado es el ChatGPT, una aplicación de chatbot de IA desarrollado en 2022 por OpenAI que es capaz de generar respuestas basadas en patrones y contextos aprendidos durante su entrenamiento.

El ChatGPT puede generar respuestas que parecen razonadas y coherentes dentro de los límites de su capacidad para entender el contexto y la información proporcionada. Sin miedo a cometer equívocos, podría afirmarse que este chatbot de IA puede hacer de casi todo: desde superar con nota un examen de abogacía hasta crear una política de recursos humanos o escribir el guion de una película.

Sin embargo, es importante destacar que ni el ChatGPT ni otros modelos similares, como LaMDA (de Google), Claude (de Anthropic), Bard (de Google) o Sparrow (de DeepMind), no poseen verdadero razonamiento o comprensión, como los que han desarrollado los seres humanos tras millones de años de evolución.

Aunque todos ellos pueden simular un tipo de razonamiento, al seguir patrones y reglas gramaticales aprendidas, carecen de una comprensión profunda, del conocimiento del mundo real y de la capacidad de razonar de manera abstracta. Son torpes a la hora de procesar información fuera de su conjunto de datos de entrenamiento o de realizar inferencias lógicas sofisticadas.

Además, el ChatGPT y sus competidores sufren una total dependencia del contexto inmediato: el ChatGPT, por ejemplo, se basa en el contexto inmediato de la conversación y no retiene información a largo plazo. Cada respuesta se genera en función de las últimas interacciones, lo que puede llevar a respuestas inconsistentes si el contexto cambia.

A la IA se le echa en falta el don de la comprensión profunda

También se les echa en falta el don de la comprensión profunda. En efecto, aunque el ChatGPT puede generar respuestas que parecen relevantes, no comprende el significado de las palabras de la misma manera que lo hace un ser humano. La IA no tiene una representación interna de conceptos abstractos ni una comprensión profunda de las relaciones causales.

Por otro lado, dado que los chatbots de IA se entrenan en grandes conjuntos de datos de la Red, pueden generar respuestas incorrectas o sesgadas, y reflejar así los sesgos presentes en esos datos de entrenamiento.

En román paladino, ni el ChatGPT ni otros modelos pueden razonar como un ser humano. Para Vered Shwartz, profesora del Departamento de Informática de la Universidad de Columbia Británica (UBC), y Mehar Bhatia, estudiante de máster en dicha universidad, el razonamiento podría ser el siguiente paso en la IA y advierten de que es importante entrenar a estos modelos con conjuntos de datos provenientes de diferentes culturas.

Pero ¿qué es tener capacidad de razonamiento para una inteligencia artificial? En una entrevista concedida por estas dos expertas al Gabinete de Prensa de la UBC, Shwartz explica que el ChatGPT y otros grandes modelos lingüísticos aprenden leyendo millones de documentos, básicamente de la web, y reconociendo patrones para producir información.

A diferencia de las IA, los humanos usamos la lógica y el sentido común para descifrar significados más allá de lo que se dice explícitamente

«Esto significa que solo pueden proporcionar información sobre cosas que están documentadas en internet. Los humanos, en cambio, somos capaces de razonar. Usamos la lógica y el sentido común para descifrar significados más allá de lo que se dice explícitamente», comenta Shwartz.

En palabras de Bhatia, los seres humanos aprendemos a razonar desde que nacemos. «Por ejemplo, sabemos que no debemos encender la batidora a las dos de la madrugada, porque despertaremos a todo el mundo. No nos lo enseñan, pero es algo que entiendes en función de la situación, de tu entorno y de lo que te rodea. En un futuro próximo, los modelos de IA se encargarán de ejecutar muchas de nuestras tareas», dice Bhatia.

En este sentido, no podemos codificar todas las reglas de sentido común en estos robots. «Así pues, lo que les pediremos es que entiendan lo que hay que hacer en un contexto específico», comenta Bhatia.

No cabe duda de que la incorporación del razonamiento de sentido común a modelos actuales, como el ChatGPT, los ayudaría a proporcionar respuestas más precisas y, por lo tanto, a crear herramientas más poderosas al servicio de los seres humanos. «Los modelos actuales de IA han mostrado alguna forma de razonamiento por sentido común —explica Shwartz—. Por ejemplo, si preguntas a la última versión de ChatGPT sobre el pastel de barro de un niño y el de un adulto, puede diferenciar correctamente entre el postre y una cara llena de tierra basándose en el contexto».

Aún no se puede evitar la intervención del hombre en los sistemas de IA

En opinión de esta informática, el razonamiento de sentido común en los modelos de IA dista mucho de ser perfecto. «Solo llegaremos hasta cierto punto entrenando con cantidades masivas de datos. Los humanos aún tendrán que intervenir y entrenar a los modelos, incluso proporcionándoles los datos adecuados», advierte.

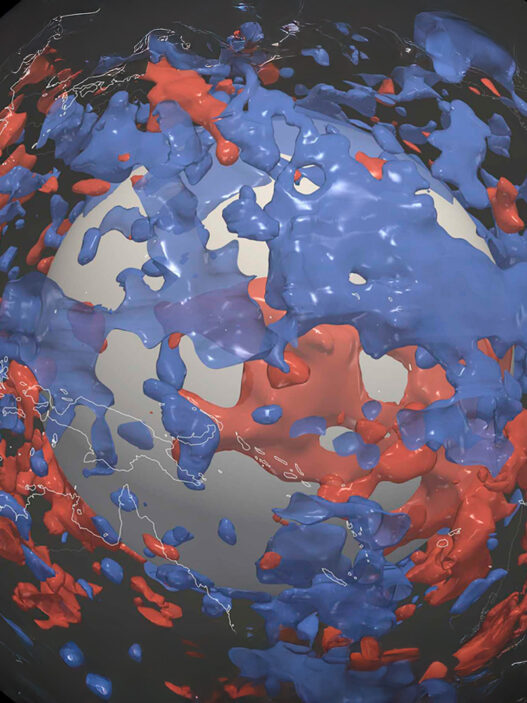

Por ejemplo, sabemos que los textos en inglés que circulan por internet proceden en gran medida de Norteamérica, por lo que los modelos en este idioma, que son los más utilizados, tienden a tener un sesgo norteamericano y corren el riesgo de desconocer conceptos de otras culturas o de perpetuar estereotipos.

«En un artículo reciente hemos comprobado que el entrenamiento de un modelo de razonamiento fundamentado en el sentido común con datos de distintas culturas, como las procedentes de la India, Nigeria y Corea del Sur, da lugar a respuestas más precisas y culturalmente más informadas», sostiene Shwartz.

Este es uno de los agujeros negros de los modelos lingüísticos de IA. Bhatia lo pone de relieve con este ejemplo: «Mostramos al modelo de IA la imagen de una mujer somalí que se estaba haciendo un tatuaje de henna, y le preguntamos por qué lo quería. Cuando se entrenó con datos culturalmente diversos, el modelo sugirió correctamente que estaba a punto de casarse, mientras que antes había dicho que quería comprar henna».

Cómo interpreta la IA la cantidad de propina que dejamos en un bar

Los expertos también se han topado con casos de falta de conciencia cultural en el ChatGPT. «Ante una situación hipotética en la que una pareja deja un 4 % de propina en un restaurante español, el modelo sugiere que no está satisfecha con el servicio —dice Shwartz. Y añade—: Esto supone que la cultura norteamericana de las propinas se aplica en España, cuando en realidad, las propinas no son habituales en este país y un 4 % de propina probablemente significa un servicio excepcional».

No cabe duda de que los investigadores inmersos en el desarrollo de inteligencias artificiales han de garantizar que la IA sea más inclusiva. Como señala Shwartz, los modelos lingüísticos son omnipresentes. «Si estos modelos asumen el conjunto de valores y normas asociados a la cultura occidental o norteamericana —explica esta experta—, su información para y sobre personas de otras culturas podría ser inexacta y discriminatoria».

Otro motivo de preocupación es que las personas de distintos orígenes que utilicen productos basados en modelos ingleses tengan que adaptar sus entradas a las normas estadounidenses o, de lo contrario, podrían obtener un rendimiento inferior al óptimo. «Queremos que estas herramientas las utilice todo el mundo, no solo un grupo de personas. Canadá es un país culturalmente diverso y tenemos que asegurarnos de que las herramientas de IA que impulsan nuestras vidas no reflejen solo una cultura y sus normas», sostiene Bhatia en la citada entrevista universitaria.

En este sentido, la investigación en curso que están llevado estas dos científicas pretende fomentar la inclusión, la diversidad y la sensibilidad cultural en el desarrollo y despliegue de las tecnologías de inteligencia artificial.

Aunque el ChatGPT y otros modelos similares son poderosos para tareas específicas, es fundamental comprender sus limitaciones y no depender de ellos para aplicaciones que requieran comprensión profunda, juicio crítico o conocimientos especializados. Están diseñados como asistentes de lenguaje y no como agentes razonadores independientes con una comprensión completa del mundo.

El desafío de razonar con sentido común

No cabe duda de que el éxito de la inteligencia artificial dependerá de que pueda razonar con sentido común, un conocimiento que vamos adquiriendo de manera imperceptible, desde el día en que nacemos, que no está escrito en ninguna parte y en el que prácticamente ni reparamos.

Numerosas universidades, organismos y empresas privadas están invirtiendo esfuerzo y dinero en dotar a la IA de una capacidad de razonamiento con sentido común.

«La falta de sentido común impide a los sistemas inteligentes entender su mundo, comportarse de manera razonable ante situaciones inesperadas, comunicarse de manera natural con las personas y aprender de nuevas experiencias —dicen fuentes de la Agencia de Proyectos de Investigación Avanzados de Defensa estadounidense (DARPA), que ha lanzado recientemente un proyecto llamado Machine Common Sense. Y añaden—: Su ausencia se considera la barrera más importante que separa el enfoque limitado de las aplicaciones de IA actuales con los sistemas de inteligencia general, similares a los humanos, que se espera desarrollar en el futuro».

Los avances en este campo son dignos de elogio. Sin ir más lejos, el pasado mes de octubre Brendan Lake, de la Universidad de Nueva York (EE. UU.), y Marco Baroni, de la Universidad Pompeu Fabra de Barcelona (España), afirmaron en la revista Nature haber diseñado una red neuronal artificial capaz de razonar de forma muy parecida a como lo hace la mente humana.